¿Agentes IA y Modelos IA pequeños (SLM), la combinación ideal?

Por: Laszlo Beke – BekeSantos.

Nuestra visión ha sido que, en el aprovechamiento de Inteligencia Artificial, las empresas usarían: (1) inicialmente la IA como un Asistente, (2) los Agentes de IA como paso siguiente y (3) finalmente aparecerían los modelos adaptados para la empresa, por sector de negocios y por función interna. Los dos primeros componentes ya están plena marcha y en BekeSantos (nuestra empresa) estamos trabajando con ellos en el Proyecto Cronos de Introducción y Aprovechamiento de la IA en la empresa. Para el tercer componente están comenzando a aparecer y utilizarse los SLM (modelos pequeños) y parecieran los primeros pasos de los eventuales modelos empresariales. Expertos reconocidos indican que los modelos de lenguaje pequeños son el futuro de la IA agéntica.

La ralentización del progreso en la vanguardia de la IA generativa es una señal de que los LLM no necesariamente están cumpliendo con las extraordinarias expectativas. Un indicio aún más relevante es el auge de alternativas más pequeñas y ágiles, que están ganando terreno en el mundo corporativo. Muchas empresas prefieren modelos en la medida que los puedan adaptar a sus necesidades específicas. Estos llamados modelos de lenguaje pequeño (SLM) son más económicos que los LLM multipropósito, cuya inteligencia casi divina pudiera ser superflua para muchas aplicaciones.

No existe una definición precisa de qué constituyen modelos de lenguaje pequeños y grandes. La distinción se reduce a la cantidad de parámetros con los que se entrenan, es decir, la cantidad de configuraciones numéricas en el cerebro de un modelo que le ayudan a interpretar los datos. Las mejoras en el entrenamiento de los modelos de lenguaje de aprendizaje de los (SLM) les han permitido alcanzar las capacidades de los modelos de lenguaje de aprendizaje (LLM). Los modelos pequeños son cada vez más «enseñados» por los más grandes, en lugar de tener que explorar la web para aprender por sí mismos. Un modelo de 9 mil millones de parámetros llamado Nvidia Nemotron Nano, lanzado recientemente por el fabricante de chips de IA, supera a un modelo Llama lanzado en abril por Meta, el gigante de las redes sociales, el cual es 40 veces más grande. La puesta al día se está convirtiendo en una rutina. Los modelos más pequeños de hoy son mucho más capaces que los modelos más grandes del año pasado. La economía es otra razón de la creciente popularidad de los SLM, por cuanto ellos permiten ahorrar dinero al realizar tareas discretas y repetibles.

Modelos para las empresas

Un mejor rendimiento de los modelos pequeños (SLM) ha atraído a clientes empresariales. Gartner, la reconocida consultora de TI, afirma que las fallas bien conocidas en los LLM, como las alucinaciones, han generado «fatiga del usuario». En cambio, las empresas buscan modelos más especializados, optimizados con datos específicos del sector. Este año, se proyecta que la demanda corporativa de estos modelos crecerá el doble de rápido que la de los LLM, aunque desde una base mucho menor. Gartner prevé que, con el tiempo, más de estos modelos especializados sean desarrollados internamente por las empresas.

LLM vs SML

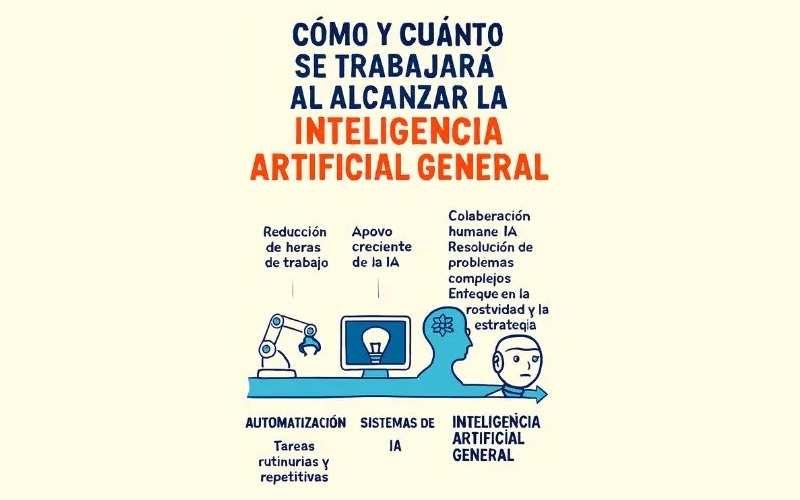

Resulta curioso que, mientras los laboratorios estadounidenses de IA invierten enormes sumas en el desarrollo de LLM omniscientes, importantes sectores del mundo creen que el futuro está en los pequeños. Un nuevo laboratorio de investigación respaldado por los Emiratos Árabes Unidos creó un SLM de código abierto llamado K2 Think, que, según afirma, supera a modelos 20 veces más grandes. China también está interesada en los SLM de código abierto. Pareciera que los laboratorios estadounidenses de IA se han centrado demasiado en los LLM en su afán por alcanzar la inteligencia artificial general (IAG). Han pasado por alto el hecho que las empresas tienen dificultades para adoptar la IA generativa incluso para tareas cotidianas; la omnisciencia de la IAG podría dejarlas perplejas.

Los usuarios de IA parecen estar divididos sobre las ventajas relativas de los SLM y los LLM. Algunas empresas consideran que los modelos pequeños son más fáciles de gestionar y manipular con sus propios datos que los monolíticos. Otras prefieren estos últimos para las tareas más complejas. Será interesante ver cómo se desarrolla esto. Cuantos más SLM utilicen los primeros usuarios, menos infraestructura en la nube podría ser necesaria, lo que plantearía serias dudas sobre la inversión de los híper escaladores en centros de datos. Dicho esto, los LLM ayudan a entrenar a los SLM, por lo que, al menos por ahora, ambos siguen estando intrínsecamente vinculados.

SML: Agentes IA

Además de ser tan fáciles de ejecutar en los sistemas informáticos internos de una empresa como a través de un proveedor de servicios en la nube, los SLM también pueden ser más útiles para los agentes de IA, que realizan tareas laborales junto con o en lugar de los humanos. Su menor tamaño los hace especialmente adecuados para la IA en smartphones, coches autónomos, robots y otros dispositivos donde la eficiencia energética y la velocidad son prioritarias.

Los SLM podrían volverse aún más atractivos a medida que las empresas implementen más agentes de IA. Los SLM son lo suficientemente potentes como para gestionar tareas agénticas y más económicos (por ejemplo, un modelo de 7000 millones de parámetros puede ser de diez a treinta veces más barato de ejecutar que un modelo hasta veinticinco veces más grande). Afirma que los SLM podrían conducir a un enfoque «similar a Lego» para la creación de agentes, con empresas que utilicen pequeños expertos especializados, en lugar de una inteligencia LLM monolítica.

Por otro lado, para ilustrar la economía, se puede señalar al producto Docling de IBM, el cual transforma documentos PDF, como recibos, en datos almacenables. Se ejecuta en un modelo «diminuto» con unos 250 millones de parámetros. Lo consideran una herramienta útil, pero que no sería rentable si se ejecutara en un LLM. Los modelos pequeños también pueden funcionar en variedades de chips más económicas. Ellos pueden utilizar unidades centrales de procesamiento (CPU), los caballos de batalla de la informática general, en lugar de unidades de procesamiento gráfico (GPU).

El futuro – dispositivos

Independientemente de si los SLM acaban desplazando a los LLM o no, la heterogeneidad está en aumento. Los LLM omniscientes seguirán siendo importantes para aplicaciones de consumo como ChatGPT de OpenAI. Sin embargo, incluso OpenAI está cambiando su enfoque. GPT-5 cuenta con modelos internos de diferentes tamaños y potencias, que utiliza según la complejidad de la tarea. A medida que los SLM se vuelven más eficaces, también podrían mejorar la reputación de la IA en el dispositivo. Sin embargo, el enfoque de la empresa de utilizar SLM para realizar algunas tareas en el iPhone mientras delega las más complejas a la nube podría ser el futuro.

Por ahora, la mayor parte de la atención se centra en los LLM. Aunque gigantes de la nube como Microsoft y Google han creado modelos extremadamente pequeños, la creencia de que el status quo persistirá ha ayudado a justificar las grandes cantidades que están invirtiendo en centros de datos para entrenar y alojar los modelos más grandes. Esto podría ser una visión miope. Dados los méritos relativos de los SLM, el enfoque de Apple de ir con calma podría resultar justificado a largo plazo.

Se hace referencia a Faith in God-like large language models is waning. La imagen es cortesía de Microsoft Copilot.